Tengo una noticia buena y otra mala para quienes piensan que el software libre es creado por personas anónimas y sin ánimo de lucro. La mala es que esa visión es tan idealista como irreal y la buena es que la mayor parte de la sociedad lo percibe de esa forma.

Nota antes de comenzar: Es importante tener claro que todo lo aquí expuesto es de aplicación únicamente a nivel empresarial. En el ámbito doméstico algunas cosas pueden no ser (y de hecho no son) correctas ni ciertas.

En el post anterior (

Microsoft: el mayor impulsor del software libre) hablábamos de los orígenes del software libre. Hoy toca hablar de su presente y si es posible de su futuro. Para ello, comencemos desmenuzando sus características fundamentales.

Flexibilidad

La idea fundamental que subyace es que si el código fuente está disponible, los desarrolladores podrán aprender y modificar los programas a su antojo, corrigiendo errores o adaptándolo para realizar tareas específicas. Además, se produce un flujo constante de ideas que mejora la calidad de los programas.

Esto es cierto entre los profesionales del software, es decir, para aquellas compañías del sector TI o para aquellas compañías que tengan la dimensión como plantearse tener personal en plantilla para la corrección de fallos en el software de base, es decir, aquel que sirve como plataforma para las aplicaciones de negocio.

Atribuyen a

Einstein la cita de que todo debe ser tan sencillo como sea posible, pero no más. En este sentido, y salvo excepciones, parece poco razonable pensar que disponer del código fuente sea una ventaja competitiva frente a los paquetes de software que no facilitan dicho código. Sería tanto como pensar que un conductor obtendría algún tipo de beneficio si el fabricante del vehículo le adjuntase los planos de ingeniería del motor. Obviamente, sería bueno para las compañías de la competencia y para algún conductor con un elevado nivel de curiosidad y conocimientos pero no para el común de los compradores de coche que prefieren centrarse en su día a día dejando el diseño de motores para aquellos con la formación y conocimientos adecuados. El razonamiento que subyace está basado en el principio Taylorista de especialización. Es más, modificar el corazón de los productos por su cuenta y riesgo (fuera del estándar) puede ser incluso contraproducente teniendo en cuenta que aumentan las papeletas en el particular sorteo de la incompatibilidad con la siguiente versión.

He de decir que no conozco personalmente a nadie que haya modificado el kernel de

Linux, ni módulos de

Alfreso o

MySQL, ni de

WMWare, ni de

Apache, ni de

Firefox... Y si conozco a mucha gente que usa todos esos productos en su día a día; aunque también conozco a los que usan las alternativas de software comercial y la verdad creo que no se diferencien en mucho.

Fiabilidad y seguridad

En este caso, la idea primigenia es que con varios programadores a la vez mirando el mismo trabajo los errores se detectan y corrigen antes, por lo que el producto resultante es más fiable y eficaz que el comercial. Es la alternativa al oscurantismo habitual de las compañías de software que únicamente reconocen los problemas de seguridad cuando no queda más remedio y cuando la explotación de estos problemas pone en riesgo los sistemas.

Tener acceso al código fuente es una ventaja en aquellos proyectos que tienen un gran respaldo de la comunidad y donde el número de desarrolladores es elevado. En este caso se cumple la premisa de que entre muchos se detectan y corrigen los problemas con mayor celeridad. Sin embargo, cuando los proyectos son pequeños y el número de desarrolladores reducido, el riesgo de permitir a cualquiera husmear en el código fuente no se ve recompensado con un gran número de personas dispuestas a solventar problemas. En este caso, menos es más y la táctica del oscurantismo utilizada por la mayor parte de las compañías de software, no permitiendo ver el código fuente a potenciales delincuentes, puede llegar a ser una estrategia más acertada.

Rapidez de desarrollo

En líneas generales se cumplen las mismas premisas que las descritas para la fiabilidad y seguridad. Cuando los proyectos no tienen mucha relevancia el número de personas es igual o inferior a los que cualquier compañía puede disponer en torno a un responsable de desarrollo de producto. Sin embargo, cuando el proyecto de desarrollo tiene mucha relevancia el número de personas dispuestas a donar su tiempo es elevado y los tiempos de desarrollo son extremadamente cortos. Un reciente estudio sobre

RedHat fijó el coste de desarrollo de este sistema operativo en torno a un billón de dólares, basando los cálculos en sus 30 millones de líneas de código, para lo que una empresa tradicional que partiese de cero debería contratar una fuerza productiva de 8.000 profesionales FTE. Es difícil pensar que una compañía privada sujeta a cuentas de resultados anuales pueda poner en nómina a un conjunto de personas como los que en ocasiones trabajan en proyectos de

Open Source.

Coste

Esta es, como no podía ser de otra forma, la piedra filosofal en torno a lo que, en la práctica gira la existencia y, por qué no, la pervivencia del software libre. Los dos mundos enfrentados se disputan ser los más eficientes en costes en las grandes implantaciones de TI y, como intentaremos demostrar, es posible que ambos tengan razón.

¿Cuánto cuesta el software libre?

Partamos de la base de que el producto de software libre a analizar es gratuito. Es decir, su código fuente circula libremente y además se puede obtener a coste cero. Este bien podría ser el caso de

Linux. ¿Querría esto decir que la comparativa entre

Windows y

Linux se resuelve mediante un “coste de licencia de

Microsoft vs cero”? La respuesta claramente es no.

Para entender los motivos que fundamentan esta respuesta se deben analizar los costes reales de los sistemas informáticos. Según un estudio de

IDC (

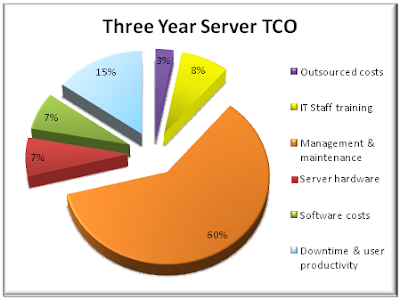

Three Year Server TCO), que en líneas generales coincide con estudios de otras consultoras, el coste total de propiedad de un sistema informático, es decir, el coste real que significa ese sistema para las compañías, tiene su sustento básico en dos conceptos: el coste de gestión y mantenimiento del mismo una vez que está en funcionamiento (60%) y el coste del no servicio y falta de productividad, es decir, el coste que significa para las compañías no disponer de ese sistema y las variaciones de la productividad en función de la aceptación de los sistemas por parte de los usuarios (15%).

A cierta distancia se sitúan otros conceptos como el coste de las máquinas y del software con un 7% cada una. Incluso los costes de formación del personal de TI (8%) se sitúan por encima de los costes del software.

Como ya se indicó, el coste más importante, con un porcentaje del 60%, es el de gestión y mantenimiento y, dado su peso en la cifra global, procede un estudio más pormenorizado del mismo.

En este concepto se engloban básicamente los salarios del personal de TI dedicado a la implantación del sistema, a garantizar el correcto funcionamiento una vez que se encuentra en funcionamiento y a resolver las consultas y problemas de los usuarios en su trabajo diario con el mismo. También se incluyen otros conceptos como el coste de soporte de las empresas especializadas, el coste de las herramientas de gestión de utiliza el personal de TI para su trabajo diario, si bien, estos costes son en general menos representativos frente al coste salarial.

Tal y como se indicó al inicio de esta sección, los sistemas informáticos basados en software libre a nivel empresarial no son, ni con mucho, gratuitos pese a que el software que los sustente se distribuya sin coste.

Es importante destacar que este micro-estudio no es extrapolable a cualquier comparativa entre software libre y comercial dado que, en cada caso, sería necesario el análisis de las alternativas, su coste de implantación y gestión, el nivel de aceptación por parte de los usuarios, etc. Por ejemplo, es previsible que en un análisis de coste total de propiedad de las herramientas ofimáticas (

Microsoft Office vs

Open Office) el concepto ‘user productivity’ tuviese un peso muy superior al que se referencia en el caso de los servidores dado que en ese estudio es el usuario quien trabaja directamente con la herramienta y, por tanto, su formación

ad-hoc e incluso sus preferencias son enormemente relevantes. Con toda seguridad, en el caso de las herramientas ofimáticas la productividad del usuario estaría cerca del 50% en peso frente al global del

TCO. De ahí que el retador en este mercado -

OpenOffice.org- tenga un asombroso parecido al líder -

Microsoft Office- en cuanto a apariencia e interfaz de usuario.

Respondiendo a la pregunta que inicia este apartado cabría decir que el coste de propiedad de los sistemas basados en software libre es razonablemente similar al de los basados en software comercial. Dependiendo del software a analizar y de las circunstancias de cada compañía (formación del personal TI en unas u otras tecnologías, perfil, conocimiento y gustos de los usuarios, costes de arrastre respecto a tecnologías preexistentes que deben ser migradas,…) será más óptimo decantarse por una u otra opción. Lo importante a tener en cuenta es que el (no) coste del software en sí mismo no es el valor diferencial.

Hay un 7% (el valor de las licencias de software) donde se puede obtener ventaja pero hay otro 93% donde en función de todo lo anterior se puede (o no) perderlo todo.

¿Quién sustenta el software libre?

Hay una pregunta que, por obvia, tal vez no haya aflorado aún: ¿de qué viven las empresas que se dedican al software libre?

El software libre ha evolucionado enormemente a nivel técnico durante los últimos años, y también lo ha hecho a nivel comercial. Hoy en día, muchas de las empresas que en su momento se iniciaron en el software libre como abanderados del mismo han sido adquiridas por las grandes corporaciones multinacionales en operaciones que, en ocasiones, han sido multimillonarias. Es el ejemplo de

Suse Linux que fue sido adquirida por

Novell (por doscientos millones de dólares),

MySQL adquirida por

Sun Microsystems (por mil millones de dólares) que a su vez ha sido fagocitada por

Oracle,

XenSource adquirida por

Citrix (por quinientos millones de dólares), y así hasta completar una extensa lista. Atención, porque hablamos de transacciones comerciales por valor de hasta 900 millones de euros o 150.000 millones de pesetas que impresiona más, en una única operación.

Esto no debería resultar extraño dado que a diferencia de lo que ocurrió en sus inicios, hoy en día el software libre es explotado comercialmente por las empresas de TI.

Las hay que buscan en el

Open Source una nueva forma de crear comunidades de usuario como mecanismo de fidelización. Como puede resultar lógico, un potencial cliente se siente más predispuesto a adquirir o continuar con un determinado software cuando existe un lazo íntimo que le une a ese producto más allá de la pura relación comercial.

Otras, en cambio, buscan en la comunidad una forma de aumentar su fuerza productiva sin incrementar por ello sus costes. Donando el código fuente en Internet, inicialmente, se produce una descapitalización en la empresa al perder una ventaja competitiva (los derechos sobre el conocimiento), permitiendo a los competidores acceder a los ‘secretos’ del producto. Pero a medio plazo esa descapitalización se ve compensada al obtener mejoras en el producto provenientes de la comunidad. Es decir, obtener mejoras en el producto a coste prácticamente cero y con la ventaja añadida de que, en ocasiones, al ser el usuario quien las realiza, éstas están totalmente alineadas con sus preferencias sin haber sido necesario un estudio de necesidades.

Hay también corporaciones que buscan en el

Open Source una forma de mermar el negocio de la competencia. En ocasiones se hace evidente como algunas compañías impulsan proyectos de software libre cediendo código fuente e incluso personal como forma de atacar los productos más rentables de sus competidores. Esta es, como es lógico, una política absolutamente legal y provechosa al ser una nueva variante de la competencia en los mercados. La comunidad se ve beneficiada al obtener recursos técnicos y económicos para sus proyectos y las compañías ven como su competidor líder tiene que destinar más recursos a potenciar sus productos para no quedarse rezagado limitando con ello su capacidad de actuación en otros ámbitos.

Y por último, existen compañías que, combinando todo lo anterior, trabajan en proyectos de

Open Source obteniendo su financiación y beneficios de la venta de licencias (que sea libre no implica que sea gratuito), soporte técnico post-venta, proyectos de implantación, cursos de formación,…

Como se observa, el horizonte está plagado de compañías que han desembarcado en el

Open Source con diferentes objetivos técnicos y comerciales. Y hay una máxima que se mantiene invariablemente constante: ninguna de estas compañías, salvo rarísimas excepciones, dona al

Open Source su producto cuando éste es líder de mercado y no hay nada en el horizonte que amenace este liderazgo.

Como ejemplo podríamos citar como

Oracle mantiene a buen recaudo el código fuente de su motor de base de datos pero al tiempo se involucra a fondo en el

Open Source en aquellos segmentos en los que no tiene presencia como la virtualización de hardware o los sistemas operativos. Incluso se da la circunstancia de que

Oracle es propietario de un motor de base de datos (el que le da nombre) y de un motor de base de datos

Open Source como es

MySQL lo que constituye, a buen seguro, un auténtico galimatías estratégico para estar presente simultáneamente en los dos mercados sin que la presencia en uno enturbie su imagen en el otro.

Tanto es así que está comenzando a tener serios problemas con la comunidad

Open Source de

OpenOffice (donde ya hay un fork oficial,

LibreOffice), la de

Linux dado que ha desarrollado un

Kernel propio (oficialmente dicen que ofrece mucho mejor rendimiento que el estándar) y ha retirado el apoyo a

OpenSolaris, la de

Java donde está en batallas legales con

Google por patentes en

Android, al de

MySQL por no fijar una clara estrategia de evolución,...

Otro ejemplo podría ser el de IBM y HP que colaboran real y muy activamente con Linux y otros productos de Open Source al tiempo que mantienen a buen recaudo sus sistemas propietarios (y rentables) como zOS, i5/OS, AIX, HP-UX, NonStop, DB2,…

Es curioso ver como el primer acercamiento de ambas compañías a un proyecto siempre es -en el 99% de los casos- con sus sistemas propietarios. Y cuando perciben que esa opción no es válida desenfundan la opción Linux. No es criticable, solo curioso.

Es previsible que las empresas que intentan mantener el equilibrio de la balanza de esta manera terminen generando fricciones con las diferentes comunidades, tal y como ya le está sucediendo a Oracle, porque no se puede estar eternamente en la indefinición.

El último de los ejemplos, por ser muy conocido, es

Google al mantener su genial mecanismo de búsqueda fuera del alcance del

copyleft al tiempo que anuncia que se involucra en el mundo de los navegadores de Internet con un producto propio en

Open Source,

Chrome. Esto, incluso, le ha costado las críticas de la comunidad de

Open Source que da soporte a

Firefox al considerar que era una actuación desleal tras haberse beneficiado del conocimiento de este proyecto durante años.

En situación muy distinta están compañías que han donado sus códigos fuente cuando han visto una merma continuada de ventas o cuando han percibido que el producto se enfrentaría a una situación complicada en el futuro. Entre las más destacadas cesiones podría citarse a

Eclipse,

Netscape o

Solaris. En el primer y segundo caso por la situación de liderazgo de

Visual Studio e

Internet Explorer y en el tercero por lo complejo que suponía para

Sun la estrategia de apoyar el software libre manteniendo un sistema operativo propietario –además de una feroz competencia por ese mercado-. No hay más que ver como

Oracle, con infinitamente más músculo financiero que la extinta

Sun, ha retirado la versión

Open Source de

Solaris para continuar el desarrollo por sus propios medios.

El

Open Source se ha convertido en la práctica en una nueva forma de concebir el negocio del software en el que se intenta contar con la colaboración y el trabajo de los usuarios para la mejora de los productos, la creación de comunidades que aumenten la fidelización y la obtención de beneficios por vías diferentes a la de la venta de licencias. Pero en definitiva, una nueva forma de entender el negocio.

Por eso, más allá del fanatismo tecnológico, el software libre de calidad será bueno cuando tras quitar el adjetivo

libre la frase aún siga teniendo sentido. Es decir, será bueno sí y solo sí el software es de calidad, si y solo sí se ajusta a las necesidades, preferencias, gustos y cultura de la compañía y si y solo sí presenta el ratio coste/beneficio más óptimo medido en términos de

TCO, independientemente de que lo desarrolle una empresa o lo desarrolle una comunidad de vecinos.

Perogrullo, vamos... ¿o no?

To be continued...

.jpg/220px-Richard_Stallman_2005_(chrys).jpg)