Sin embargo, la Green IT no acaba de ser del todo creíble y es que según parece hay algunos factores que nos hacen pensar que la contaminación y los elevados consumos de energía no tienen una clara relación con las Tecnologías de la Información.

Y como veremos esa relación existe y es probablemente muy superior a la que a priori podría parece razonable.

Factor 1. Las empresas de tecnología también son contaminantes

¿Son contaminantes Facebook o Twitter? Hemos elegido estas dos compañías para la pregunta porque ambas se dedican, en exclusiva, al software. Además, lo hacen en modo Cloud con lo que tampoco distribuyen sus productos en CDs empaquetados en cajas de cartón. No producen nada que sea tangible y, por tanto, muchas personas pensarán que no son contaminantes. Pero todas ellas se equivocarán.

Probablemente, contaminan menos que algunas fábricas pero no se puede decir, en absoluto, que sean inocuas con el medio ambiente. Porque los CPD no son ecológicamente neutros.

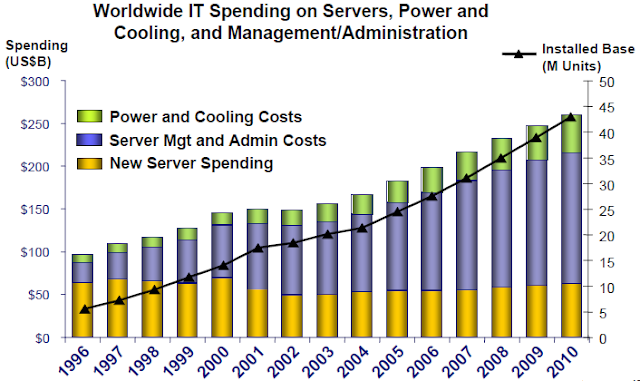

Un interesantísimo estudio de Electronics Cooling concluye que desde el 2001 los costes de infraestructura y energía son mayores que los costes de adquisición de los servidores del Data Center. Y más aún, desde 2008 únicamente los costes de energía son ya superiores a las inversiones en compra de servidores; y la tendencia dice que seguirán aumentando.

Es cierto que se ha mejorado algo en los últimos años pero el avance es realmente pobre cuando se compara el aumento de potencia real de las infraestructuras con el aumento de potencia por vatio consumido.

Es decir, en su mayor parte se consigue más rendimiento, año sobre año, a base de consumir cada vez más energía. La Ley de Moore no se cumple en absoluto en lo que se refiere al consumo de energía.

Las principales organizaciones ecologistas son conscientes del problema desde hace tiempo pero, probablemente, uno de los puntos de inflexión en su comportamiento frente a la producción de TI cambió a principios de 2010 con la decisión de Facebook de instalar un nuevo Data Center en Oregón (USA) alimentado básicamente por energías no renovables. El vídeo de Greenpeace no tiene desperdicio.

Lo que se dice de Facebook en la parte final del vídeo es probablemente aplicable al resto de la industria TI salvo algunas honrosas excepciones como la de Google que destina una importante partida económica al estudio de energías renovables y eficiencia energética a través de su plan Energía limpia 2030. De hecho, sus Data Centers son de los pocos que pueden presumir de un PUE (Power Usage Effectiveness) en torno a 1,1 cuando la media mundial está muy por encima de 2,0. Es decir, sus Data Centers consumen menos de la mitad de energía que la media, lo que les permite ser muy verdes y de paso ahorrarse una importantísima cantidad de dinero teniendo en cuenta que algunas estimaciones apuntan a que las TI suponen entre un 1 y un 2 por ciento del consumo energético mundial.

Nota: Un Data Center con un PUE de 2,0 implica que por cada vatio consumido en los equipos de TI se consume otro, fundamentalmente, en refrigeración.

Este consumo desmesurado de energía no es solo aplicable a los gigantes de TI sino que en menor medida se da en cada uno de nuestros Data Centers. Mientras no seamos plenamente conscientes de que la producción de TI es también contaminante no habrá presión suficiente sobre el mercado como para hacer variar algunas tendencias.

Factor 2. Estamos cansados de agoreros

Este factor no es exclusivo de la industria de las TI pero le es de plena aplicación. La debacle de las teorías fatalistas propugnadas por Al Gore ha hecho un enorme daño a la imagen de lo que en general pensamos del cambio climático. Y más aún si tenemos en cuenta que Al Gore no ha sido el primero en cometer el error de ser excesivamente fatalista. Leamos con atención el siguiente texto de SuperFreakonomics (aviso que tiene truco):

...solo en Estados Unidos, las grandes ciudades adquirieron treinta millones de nuevos residentes. Y a medida que el enjambre humano se desplazaba, junto con sus posesiones, de un lugar a otro, surgió un problema. El principal medio de transporte producía grandes cantidades de subproductos que los economistas llamaban externalidades negativas, que incluían atascos, grandes gastos en seguridad y demasiados accidentes mortales de tráfico. En ocasiones, cosechas que deberían haber ido a parar a la mesa de una familia se transformaban en combustible, haciendo subir los precios de los elementos y causando escasez. Y también estaban las emisiones contaminantes y tóxicas al aire, que ponían en peligro el medio ambiente y la salud de los individuos.

¿Hablamos de las ciudades de finales del siglo XX y principios del XXI y de los problemas del tráfico rodado? Pues no, es un texto que aplica a finales del siglo XIX y el medio de transporte al que se hace referencia es el caballo. El automóvil, más barato en precio y mantenimiento que un vehículo tirado por caballos, fue proclamado como salvador del medio ambiente. Recomiendo repetir la lectura tras conocer la época de la que se trata.

Uno de los principales problemas que tiene la ecología, y le aplica de lleno a la industria de TI, es que muy en el fondo pensamos que antes de que haya una debacle por el uso de un determinado tipo de energía seremos capaces de descubrir una nueva fuente energética que resolverá los problemas de la anterior, aunque en el futuro cause otros. Por eso no hacemos demasiado caso a los agoreros; todo parece ser una cuestión de coste-beneficio si atendemos a las teorías de Schumpeter y su destrucción creativa.

Factor 3. Quienes más propugnan Green IT no son precisamente un buen ejemplo

Por un lado ya hemos visto que hay un enorme desfase entre los aumentos de potencia real del hardware y el aumento de potencia por vatio de energía consumida. Es decir, los equipos consumen cada vez más energía, lo que es especialmente cierto en máquinas con alta densidad de componentes como los elementos de red (switches, routers, appliances,...).

Pero son aún peor ejemplo si tenemos en cuenta que el consumo energético de un dispositivo electrónico puede llegar incluso al 30 o 40 por ciento antes de que se pulse el botón de ON. Es decir, el consumo energético necesario para su fabricación puede suponer el 30% de todo el consumo de ese dispositivo durante su vida útil. Esto es especialmente cierto en el caso de los teléfonos móviles y en elementos de máxima integración (servidores pizza, blades, tablets, elementos de red,...) donde el consumo es reducido por unidad pero el coste energético de su producción es elevado.

Por tanto, pese a los cantos de sirena para renovar equipamiento por otro de mayor eficiencia energética, lo más ecológico que se puede hacer es intentar alargar la vida del equipamiento, lógicamente hasta donde sea razonable para evitar la Ley de Murphy. Porque el coste energético de fabricación del nuevo dispositivo será mucho mayor que los potenciales ahorros que generará frente a los equipos actuales. Todo ello sin contar con los enormes costes medioambientales que supone su posterior reciclaje.

Nuestros deseos para el Nuevo Año

Dadas las fechas en las que estamos creo que procede hacer propósitos de enmienda para el Nuevo Año. Ahí van algunos que se me ocurren.

Para nosotros: probablemente, como consumidores y gestores de tecnología lo más ecológico que podemos hacer es intentar alargar la vida del hardware que gestionamos, bien sean PCs, servidores, elementos de red, almacenamiento, teléfonos móviles,... o cualquier otro dispositivo electrónico. Alargar un año más su vida útil implica una reducción enorme en el consumo de energía y además es más que probable que hagamos muy feliz al CFO de la compañía.

Para los fabricantes de hardware: el consumo eléctrico de los equipos debe ser, como mínimo, constante. No es sostenible que cada vez que aparece una nueva revisión de los procesadores o memorias consuman un tanto por ciento más que los anteriores.

Para los fabricantes de software: los fabricantes de killer applications como, por ejemplo, Office o el propio Windows, no pueden seguir incrementando los requisitos de hardware al ritmo actual, máxime cuando los incrementos no están justificados en aumentos de productividad como, por ejemplo, Aero. Esto es también de máxima aplicación para software muy demandante de recursos como, por ejemplo, los antivirus e incluso para nuestros propios departamentos de desarrollo de aplicaciones. Hacer código más eficaz está directamente relacionado con el aumento de la vida útil de los equipos y esto lo está con el consumo energético.

Para los telcos: que dejen de incentivar el consumo desmesurado de terminales móviles. El tiempo de rotación (el tiempo de vida de los teléfonos) baja en picado y debe estar ya cerca del año. Además, tarde o temprano, acabarán por darse cuenta de que, al margen de la ecología, esto es un problema en sí mismo para ellos.

Para el legislador: quien puede regular los mercados tiene en su mano implantar un mecanismo de medición de eficiencia energética en todos los dispositivos tal y como ya se hace con los electrodomésticos. Así podremos comparar cosas homogéneas. La información y transparencia hace que los mercados funcionen mejor y sean más eficientes en todos los sentidos.

www.tonsofit.com